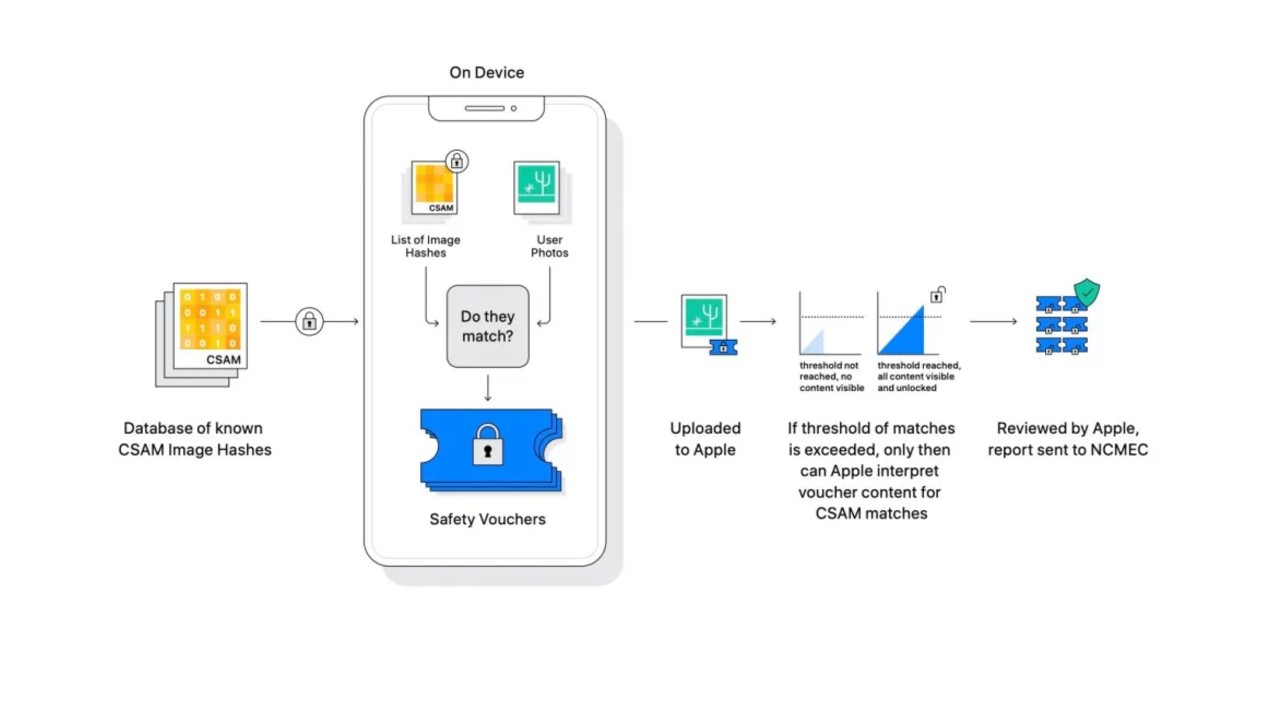

Kullanıcılarının güvenliği konusunda bir hayli çaba sarf eden Apple, geçtiğimiz hafta çocuk istismarını engellemeye yönelik yeni özelliği CSAM'i duyurmuştu. Bu özellik, bu yılın son aylarından itibaren iCloud sistemine yüklenen fotoğrafları tarayacak ve çocuk istismarına yönelik bir fotoğraf tespit ettiği anda fotoğrafı bulanıklaştırarak, kullanıcıya bildirim gönderecek.

Apple her ne kadar bu sistemin sadece çocuk istismarını tetikleyen fotoğraflarda çalışacağını vurgulasa da insanlar, Apple'ın kullanıcılarının özel hayatlarına çok daha kapsamlı bir şekilde dahil olabileceği konusunda endişeli. Ayrıca Apple'ın çocuk istismarcısı tespit ettiği anda bunu hükümete bildirmesi beklenirken, Apple tarafından böyle bir anlaşmaya varılmayacağı yönünde yeni bir açıklama geldi.

Sebebi ne olursa olsun kullanıcı verileri hükümet ile paylaşılmayacak

ABD gibi onlarca ülkede, çocuk istismarına yönelik fotoğraf veya video bulundurmanın yasalar gereğince bir cezası bulunuyor. Apple'ın çocuk istismarını engellemeye yönelik atmış olduğu bu adımdan sonra, hükümetin Apple'dan çocuk istismarında bulumduğu tespit edilen kullanıcıların bilgilerin paylaşması bekleniyor. Ancak Apple, şimdilik sadece ABD sınırları içerisinde uygulanmaya başlanacak CSAM sisteminde, sebebi ne olursa olsun kullanıcılarını ifşalayamayacağını belirtiyor.

iCloud'a yüklenen çocuk istismarına yönelik herhangi bir fotoğraf, Apple'ın CSAM sistemi sayesinde tespit ediliyor ve ilk önce görüntü bulanıklaştırılarak, kullanıcıya bildirim gönderiliyor. Apple, birden fazla bildirim alan kullanıcıları üzerinde bir araştırma başlatıyor ve sadece kendisinin gerekli gördüğü kişileri Ulusal Kayıp ve İstismara Uğramış Çocuklar Merkezi'ne bildiriyor.

Olayın tamamen Apple'ın ellerinde kalması, elbette birçok kişiyi ve özellikle devletleri endişelendiriyor. Zira devletler, kendi sınırları içerisinde çocuk istismarına meyilli insanlar varsa bunları tespit etmek ve gerekli işlemleri yapmak istiyor. Bu bağlamda hükümete yardım edemeyeceğini belirten Apple, hükümetten gelen talepler doğrultusunda CSAM sistemini hiçbir şekilde genişletmeyeceklerini dile getirdi. Apple, bu sistemin sadece çocuk istismarına yönelik fotoğrafları tespit etme amacıyla geliştirildiğini, sebebi ne olursa olsun kullanıcı verilerinin hükümet ile hiçbir şekilde paylaşılmayacağını belirtti.

Türkiye'nin en güncel forumlardan olan forumdas.com.tr'de forumda aktif ve katkısı olabilecek kişilerden gönüllü katkıda sağlayabilecek kişiler aranmaktadır.

Türkiye'nin en güncel forumlardan olan forumdas.com.tr'de forumda aktif ve katkısı olabilecek kişilerden gönüllü katkıda sağlayabilecek kişiler aranmaktadır.