MIT’ın Bilgisayar Bilimleri ve Yapay Zeka Laboratuvarı’ndaki (CSAIL) araştırmacılar, nesneleri gördüğünde hissedebilen bir robot geliştirdi. Yeni yapay zeka, sadece bakarak nesnelerin nasıl hissettirebileceğini kavrayabilecek. Robot, bu özelliğin yanı sıra dokunarak nesnenin nasıl görüneceğini de tasvir edebilecek.

CSAIL’de doktora mekteplisi ve sistem hakkındaki araştırmanın başyazarı olan Yunzhu Li, projenin robotların gerçek yerküredeki nesneleri denetim etmelerini kolaylaştıracağını bildirdi ve şu açıklamada bulundu:

“Modelimiz, sırf bakarak düz bir yerin ya da keskin bir nesnenin nasıl hissettireceğini hayal edebiliyor. Görsel data almadan etrafı dokunarak keşfettiğindeyse modelimiz etrafını kestirim edebiliyor. Bu iki duyuyu bir araya getirdiğimizde robotları güçlendirip nesneleri kavramak ve manipüle etmek için gereken olguyu azaltabiliriz.”

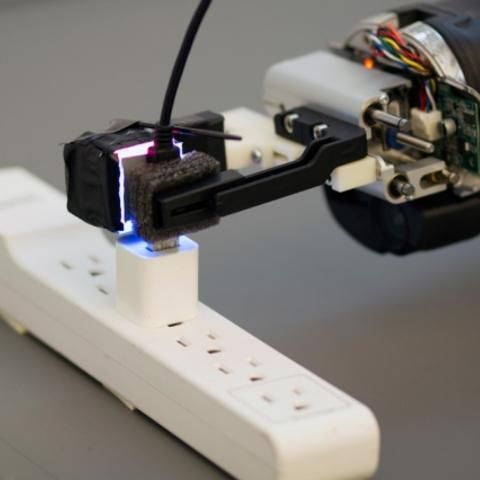

Araştırma ekibi, modeli eğitmek için içerisinde dokunma duyusuna sahip sensörler bulunan, GelSight isimli bir KUKA robot kolunu kullandı. Bu eğitimin akabinde model 200 adet nesneye 12.000 sefer dokunarak görsel ve dokunsal doneleri kaydetti. Bu olgulara dayanarak 3 milyon görsel dokunsal imge oluşturuldu ve bu imgelere VisGel ismi verildi.

Aşağıdaki görüntüde 48’inci saniyeden itibaren GelSight teknolojisinin kullanıldığı ve kullanılmadığı testi karşılaştırmalı bir biçimde izleyebilirsiniz.

Türkiye'nin en güncel forumlardan olan forumdas.com.tr'de forumda aktif ve katkısı olabilecek kişilerden gönüllü katkıda sağlayabilecek kişiler aranmaktadır.

Türkiye'nin en güncel forumlardan olan forumdas.com.tr'de forumda aktif ve katkısı olabilecek kişilerden gönüllü katkıda sağlayabilecek kişiler aranmaktadır.